时间总是很快的

最前面要说的话

感谢苟神

感谢天恒巨巨

感谢所有借过饭卡的人 ʕ •ᴥ•ʔ

开始从头说起

当时提前一天来的,就开始了看ng的网课。

然后实现了第0个lab的优先队列

heap!

数据结构加深理解

hackinit

八十进前十,第七,fake奖品

(workshop)

回来后,

爆肝赶进度,做完LLRBT实现set容器

看算法。看stl详解。

当时出现了一些bug,还是用printf debug法

接下来进入ml的学习

Linear algebra(特征分解、Moore-Penrose伪逆、迹运算)、概率与信息论(常用概率分布、Bernoulli分布、 Multinoulli分布、高斯分布、指数分布和Laplace分布、Dirac分布和经验分布)、数值计算(Hessian)

我对模型的总结

监督:(对样本的适应性+学习结果的限制的合理性)的最优化

如果按照适用问题分类

函数:

部分model之间的关系

model的学习策略上和学习算法上对比:

dl:

卷积运算

通过三个重要的思想: 稀疏交互(sparse interactions)、参数共享(parameter sharing)、等变表示(equivariant representa- tions)。

稀疏交互:使核的大小远小于输入的大小来达到的。举个例子, 当处理一张图像时,输入的图像可能包含成千上万个像素点,但是我们可以通过只占用几十个像素点的核来检测一些小的有意义的特征,例如图像的边缘。意味着我们需要存储的参数更少,而且提高了它的统计效率,更少的计算量。

参数共享:在一个模型的多个函数中使用相同的参数。传统权重矩阵的每一个元素只使用一次,当它乘以输入的一个元素后就再也不会用到了。在卷积神经网络中,核的每一个元素都作用在输入的每一位置上。参数共享保证了我们只需要学习一个参数集合,而不是对于每一位置都需要学习一个单独的参数集合。把模型的存储需求降低至 k 个参数,并且 k 通常要比 m 小很多个数量级。m大概等于n,故·k相对于 m × n 是很小的。总之存储需求和统计效率优于稠密矩阵的乘法运算。

平移等变:如果一个函数满足输入改变,输出也以同样的方式改变这一性质,我们就说是等变的。如果我们把输入中的一个事件向后延时,在输出中仍然 会有完全相同的表示,只是时间延后了。图像与之类似,卷积产生了一个 2 维映射 来表明某些特征在输入中出现的位置。如果我们移动输入中的对象,它的表示也会 在输出中移动同样的量。

池化)

rnn

实现cnn,word2vec,用tf实现rnn、LSTM

把每一个词都转一个向量,然后文章就变成了稀疏矩阵,比如说如果是文本分类问题,就把每一个词对应的向量加在一起统计次数

word2vec有CBOW(类似于蒙特卡洛模拟,只需训练一个二元的分类模型)和skip-gram(目标词汇高频率)两种模式,选后者训练很快而且计算loss function效率高。

间隔太远的输入信息,rnn难以记忆,叫做longterm dependence是传统rnn硬伤。LSTM(1997)内部结构很复杂,包含四层,state在LSTM单元中流动时,每个单元有三个gates,可以对state储存和修改,来实现长程记忆。

bi-rnn

普通的mlp对数据长度有限制,虽然rnn可以处理不固定长度的时序data,但是无法利用某个历史输入的未来信息。而bi-rnn将时序相反的两个rnn连接到同一个输出,可以同时获取历史信息和未来信息。

特别是在于需要content的时候非常有用,比如手写文字识别,前一个单词和后一个单词,比如上下文语境做mt任务。

问题在于虽然两个不同时序方向的rnn没有交集可以分开训练(不共用state),但是bptt不能同时更新状态和输出,要人工。

文本分类问题

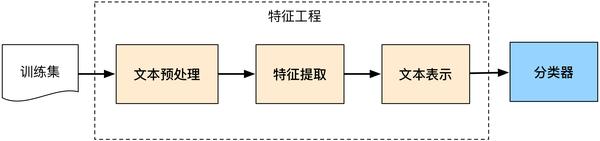

一传统

文本分词和去停用词+词袋模型(BOW, Bag Of Words)或向量空间模型(Vector Space Model)+常用的评价有文档频率、互信息、信息增益、χ²统计量+分类器

二深度

文本的分布式表示:词向量(word embedding)+词向量解决了文本表示的问题,文本分类模型则是利用CNN/RNN等深度学习网络及其变体解决自动特征提取(即特征表达)的问题。

5种CNN/RNN及其变体的模型:

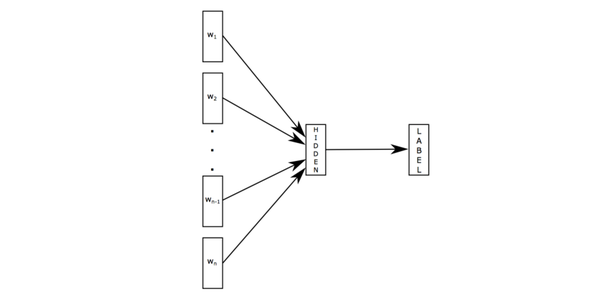

1)fastText

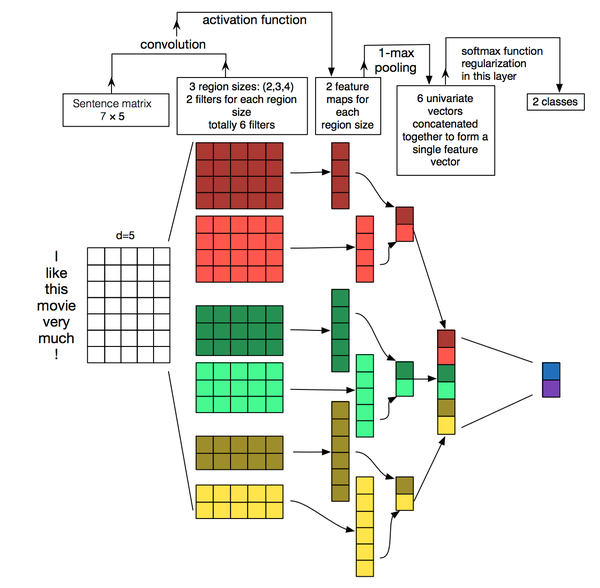

2)TextCNN

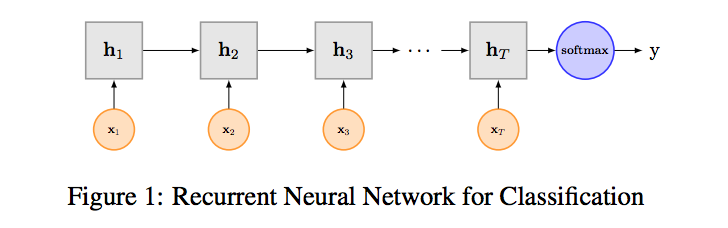

3)TextRNN

bi

4)TextRNN + Attention

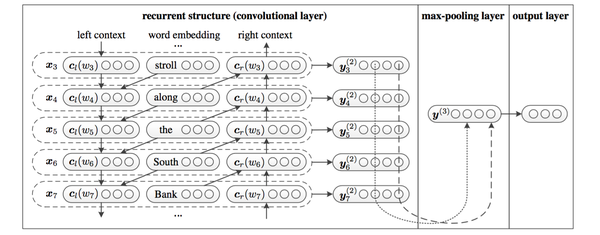

5)TextRCNN(TextRNN + CNN)(aaai2015)

还有shell lab!

|

|

hackweek

同义词汇聚类

博客上的总结和笔记:

回顾和期望

这一个月,基本上保持了日均在团队12个小时,当然也有经常通宵,经常爆肝。

不过却是挺喜欢十点到十点的生活

而且,更值得开心是在学自己喜欢的东西,在做自己喜欢的事,所以才挺有动力的。

囿于时间,未尽之处:Semi-Supervised Learning、PGM的实现、强化学习、评测比赛、prml

进一步学习,目标:ai lab

承诺:若有幸留下来,因下学期课较少,能保证周一至周五至少三个半天,周六周日必来。

来团队里面,可以和大家多交流,收获成长也会更快

再次谢谢学长们